widzieliście listę 5 największych dostawców komórek ?

Co ciekawe - z listy wypadły Xiaomi i Lenovo - obydwa doświadczyły załamania sprzedaży. Wskoczyły OPPO i Vivo...

a tak lista 5 wielkich dostawców wyglądało rok temu:

Forum > Mobilne > Zapowiadane nowe topowe telefony i tablety.... na co czekamy? vol 2

Wysłane 2016-04-28 18:34 , Edytowane 2016-04-28 18:37

Wysłane 2016-04-28 19:08 , Edytowane 2016-04-28 22:23

aż spojrzałem na flagowce tak nieznany u nas a popularnych w Azji firm

Oppo R9 - zerżnięta kopia iPhone 6S, włącznie z kolorem

Vivo Xplay 5 - jeszcze bardziej zerżnięta kopia Samsunga S6 Edge....

prawie oryginały za 1/3 ceny....

Wysłane 2016-04-28 20:37 , Edytowane 2016-04-28 20:53

@straszny

To nie jest tak, że zróbmy ARM 90W i będzie wydajniejszy od x86.

To są dwie skrajne architektury.

ARM jest, w uproszeniu mówiąc, prosty jak konstrukcja cepa. Bardzo mały zestaw prostych instrukcji. Tak jak sama nazwa wskazuje - RISC (Reduced Instruction Set Computing). Taką architekturę bardzo ciężko skalować.

Z kolei x86 operuje na bardzo dużym secie skomplikowanych instrukcji, gdzie na raz może wykonać wiele operacji - CISC (Complex Instruction Set Computing). Zamieszczałem wcześniej pewne opracowanie na ten temat.

My jedynie możemy gdybać, dopóki ktoś nie zrobi procka ARM 90W.

Patrząc na https://en.wikipedia.org/wiki/ARM_architecture widać, że ARM też się rozrasta, dodają nowe instrukcje, koprocesory. Jeszcze może się okazać, że w przyszłości budowa i zasada działania ARMa będzie zbliżona do x86

Również też nie jest tak, że nie byłoby zastosowania ARM 90W, bo wszędzie siedzi Intel i brak softu.

Dla zastosowań profesjonalnych w serwerowniach jest bez różnicy jaki procek będzie siedzieć. Tam się tworzy soft dedykowany.

Zwróć uwagę, że kolejny rok znowu wałkujemy to samo, a wciąż nie ma takich armów. Co się stało z zapowiedziami AMD?

Wysłane 2016-04-28 21:12

Tyle, że serwerowni jest za mało, żeby opłacało się ARM specjalnie dla nich tworzyć i być może ktoś napisze dedykowany soft i zostanie pionierem. Po prostu musi minąć trochę czasu i gier. Bo tak naprawdę to te ostatnie napędzają najbardziej sprzęt. Nie zastosowania pro, ale gry czynią to wszytko opłacalnym.

Wysłane 2016-04-28 21:41 , Edytowane 2016-04-28 21:57

Prawie połowa zarobków intela pochodzi z rynku serwerowego. To za mały rynek aby robić ARMy?

[LINK]

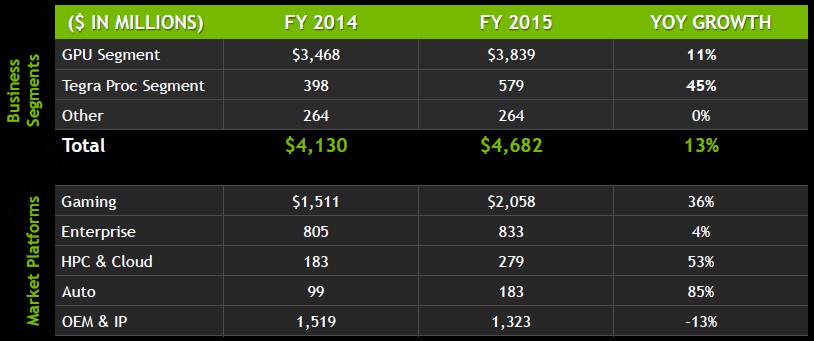

Nvidia to samo, posiada duży udział rynku serwerowego (względem rynku gamingu).

Soft nie jest tu absolutnie problemem. Zresztą, większość serwerów pracuje pod różnymi odmianami Linuxa ;)

Wysłane 2016-04-28 22:00

@Netman

Pewnie dlatego Apple przeszło kiedyś z PPC na x86 - bo osiągnęli kres ówczesnej architektury.

Na upartego x86 samo z siebie też jest przecież niewiele warte - siła tkwi w dodatkowych instrukcjach jak MMX SSE AVX itp. Koprocesory/FPU to wiadomo ale w PPC czy wcześniej M68k też były.

Wysłane 2016-04-28 22:04 , Edytowane 2016-04-28 22:13

A propo Intela...

Intel tydzień temu ogłosił zwolnienie.... 12 000 osób. Jest to największa fala zwolnień w historii firmy i obejmuje ponad 11% całej załogi.

Firma ogłosiła że rusza wielki proces zmiany z PC-company (cokolwiek by to nie miało oznaczać) w wielki Data-Center i skupienie na Internecie Rzeczy.

http://www.fool.com/investing/general/2016/04/19/intel-to-lay-off-1200...

Wysłane 2016-04-28 22:11 , Edytowane 2016-04-28 22:17

@djluke

O ironio, PPC jest RISC, tak jak ARM ![]()

W sumie nigdy nie wgłębiałem się w PPC, ale podejrzewam, że po prostu tak historia się potoczyła (coś jak DX vs OGL) ![]()

@straszny

Rynek serwerowy będzie żyć i rozwijać się. Mocy w serwerach jest zawsze za mało w przeciwieństwie do mocy w budzie u Kowalskiego (chyba, że programy pocztowe zaczną wymagać i7 ![]() ). Taka decyzja Intela to była tylko kwestia czasu.

). Taka decyzja Intela to była tylko kwestia czasu.

Wysłane 2016-04-28 22:17 , Edytowane 2016-04-28 22:26

zaraz zaraz - 1084 ma racje - to kwestia czasu, napisania gier, pogłębienia ekosystemów (Android, iOS, ChromeOS, Windows?) itd... rynek ARM akurat rośnie na drożdzach cały czas

w tej chwili, w zeszłym roku pobił niesowite rekordy a na świecie sprzedano 15 miliardów procesorów ARM

/cdn0.vox-cdn.com/uploads/chorus_asset/file/6362187/Screen%20Shot%202016-04-19%20at%206.40.06%20PM.png)

Intel popełnił dwa gigantyczne błędy:

pierwszy - gdy Paul Otelini odrzucił propozycję Stifa skonstruowania specjalnego procesora do obmyślanego wtedy iPhona (2005) - Otellini przyznał wiele lat później że nie wierzył że Apple sprzeda jakiekolwiek sensowne ilości zaawansowanych telefonów i że generalnie nie będzie na nie zbytu.

...za tym błędem poszedł mały już, bedący konsekwencją ogromnego błędu percepcji - Intel w 2006 roku sprzedał swój dział ARM (lol) - XScale. Uważając że nie ma przyszłości takiej jak x86

Drugi gdy już czuli że mobilki "zjedzą świat" - w 2011 Intel zadeklarował że chce być głównym i największym producentem w świecie Androida... tyle że nie poszły za tym żadne rewolucyjne inwestycje ani zmiany firmy.

Wysłane 2016-04-28 22:20 , Edytowane 2016-04-28 22:21

@ straszny

Nikt tego nie neguje, pokazałem tylko, że biorąc wyłącznie pod uwagę rynek serwerowy opłaca się stworzyć ARM 90W

Ps A to nie jest tak, że najpierw coś powstaje na rynku profesjonalnym aby później weszło pod strzechy? ![]()

Wysłane 2016-04-28 22:26

@Netman

Ja wiem że PPC to RISC, w końcu miałem A500 ![]() dlatego napisałem że pewnie dlatego Apple przeszło na iCore* bo im się architektura skończyła.

dlatego napisałem że pewnie dlatego Apple przeszło na iCore* bo im się architektura skończyła.

* o kurde! a może oni dlatego przeszli! w sensie że iCore! ![]()

Wysłane 2016-04-28 22:29 , Edytowane 2016-04-28 22:34

@ straszny

Wiesz, naukowcom marzy się moc tak duża, aby symulować cały wszechświat ;)

Tu nigdy mocy nie będzie za dużo, chyba że jakaś firma X wyskoczy z nowym typem procków i wszystkie Intele i ARMy pójdą z torbami ;)

Swoją drogą, coś ktoś słyszał co się stało z projektem serwerowych ARM od AMD?

Nvidia też chyba coś zapowiadała? ![]()

Wysłane 2016-04-28 22:49 , Edytowane 2016-04-28 22:51

djluke Ale A500 miała motorolkę a nie RISC dopiero turbo do A1200 I 4000 miały PPC.

netman

Wiesz, naukowcom marzy się moc tak duża, aby symulować cały wszechświat ;)

Mają mocy do bólu, tylko brak sensownych programistów. Mało to mocy obliczeniowej daje Google w swoich usługach?

Wystarczy odpowiednio to oprogramować i masz giga serwer.

Wysłane 2016-04-28 22:52 , Edytowane 2016-04-28 23:27

@ 1084

Zrób symulację wszystkich atomów znajdujących się we wszechświecie ;)

Naukowcom jest za mało mocy z kompów TOP500, a Ty porównujesz do tego chmurę Googla?

Nawet daleko nie szukając przykładu. Dane z CERN są obrabiane przez lata zanim da się z nich odczytać coś sensownego. LHC generuje 30PB danych rocznie. Dodatkowo z Wiki:

The LHC Computing Grid had become the world's largest computing grid comprising over 170 computing facilities in a worldwide network across 36 countries

Ledwo starcza nam mocy na przeanalizowanie zderzenia mikroskopijnej wiązki protonów.

Ale to na pewno wina tych nieudolnych programistów przy największym i najdroższym eksperymencie świata

Wysłane 2016-04-28 23:06

@1084

No to pprzecież napisałem że PPC wywodzi się z m68k ![]()

Wysłane 2016-04-28 23:38

netman

to na pewno wina tych nieudolnych programistów

No pewnie. Ja pisałem dema w asemblerze które liczyły nawet na chipie od stacji dyskietek. Dzisiejsi programiści piszą tak niechlujnie i tak marnotrawią moc obliczeniową, że te programy mogły by być co najmniej 3-4 razy wydajniejsze, a pewnie i więcej.

Wysłane 2016-04-29 08:38 , Edytowane 2016-04-29 08:45

@1084

to co napisałeś to tylko teoria - wcale nie marnotrawią.

(prawie) każdy z nas pamięta tamte czasy i optymalizację każego bajta - ale to było wymuszone bo nie miałeś:

a) przestrzeni ramu i dysku na pisanie obiektowe

b) mocy obliczeniowej potrafiącej z napisanych obiektowo programów korzystać

każdy bit i każda drobina mocy musiała być wykorzystywana co do jednego wpisu

a za to miałes za to sporo czasu na dziubanie ;)

przy tak skomplikowanych programach jak pisze się obecnie nie ma mowy o pisaniu w ten sposób - nie ma na to czasu, a struktura programu jest totalnie nieprzejrzysta i uniemożliwa przejrzyste nanoszenie poprawek.

Wyobraź sobie regularne updatey programów napisanych w assemblerze. Już nie mówiąc o rozbudowie o kolejne moduły. To byłoby największe marnotrawstwo bo marnotrawstwo czasu specjalistów, który jest o niebo więcej wart niż moc komputerowa obecnie (ze wzrostem mocy komputerów następuje inflacja jej wartości - inaczej była warta moc komputerowa w czasach komputerów 4bitowych, inaczej w czasach 8 i 16 bitowych, zupełnie inaczej jest współcześnie)

Kto jest online: 0 użytkowników, 321 gości