Wysłane 2013-02-10 19:13

, Edytowane 2013-02-10 19:25

@straszny

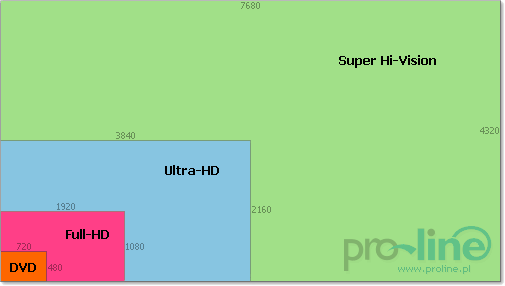

Teraz nie będzie można powiedzieć, że takie rozdzielczości (4-8K) psują nam wzrok jak te SD 480p.

Jak tyle czasu jeszcze upłynie to na kilka lat przed 50-tką się dopiero nacieszę takimi filmami.

I znów najlepsze hity filmowe się od nowa obejrzy. Jak widzę jakość HD w TV to widać tą kompresję, a to nie jest to jak film w HD w MKV odtwarzany z HDD.

Pierwsze próbki HD 720/1080p miałem w 2004r, a po roku pierwszy film w MKV w HD. Dla samego HD 720p w porównaniu do DVD (MPEG2 - 720x576) to była duża różnica jakościowa. Jak tylko pierwszy film zobaczyłem to szybko zakończyłem zakup filmów DVD (2005-2007r.). A pamiętam jeszcze ledwo epokę czarnobiałego TV z CRT Unitry z lampami elektronowymi. Jak tylko do małego TV 5.5" czarnobiałego podłączyłem tuner DVB-T to jakość cyfrowa była idealna dla niego. Jeszcze pamiętam na nim kablówkę, ale ta jakość nie była taka dobra z uwagi na analogowy sygnał SD.

AMD Phenom II X2 BE 555 (3.2 GHz), 3x Geil DDR3 1333 2 GB, 1x Samsung DDR3 1333 2 GB, MSI MS-7646 (AMD RX780 + AMD K10 IMC), Gigabyte Radeon HD6670 1 GB DDR3, Kingston SSD V300 120 GB, Samsung HDD F4EG HD204UI 2 x 2 TB, Samsung SSD 850 EVO 250 GB, Samsung SSD 850 EVO 2 x 500 GB, WD HDD WD20EURX 2 TB, Akasa PaxPower 400W AK-P400FG BL, Creative GigaWorks ProGamer G500 5.1 + Cam Video IM Skype Edition (VF0220), Samsung LCD 19" SM 940BW, Asus Xonar DX 7.1 PCI-E, TP LINK TL-WN551G 54 M PCI, 3R System R101 - obudowa ATX, Kingston - czytnik kart pamięci, LC-Power LC-CFC-1 - kontroler wentylatorów z 5,25" LCD touch-screen + 2 x LC-ADA-525-4x25-SWAP - kieszeń 5,25" dla 4xSSD 2,5", mysz Gaming, mysz Tracer Gamezone XO, klawiatura Corsair K55 RGB PRO Gaming, Brennenstuhl Primera-Tec Automatic - listwa zasilająca.