Dwa Radeony - Dwie generacje...

Strona 2 - Podsumowanie

Aby nie było gadania, Vegę 64 Liquid Edition udało mi się odkupić od znajomego, za 1500 PLN, więc ten artykuł, to nie jakaś promocja. Po prostu chcę Wam opisać niektóre zdarzenia, mogące przytrafić się w przesiadkę z jednej generacji, na drugą. Do tego ceny Radeonów serii Vega i RX znacząco spadają, co przy premierze nowych kart Nvidii, jest naprawdę okazją. Oczywiście Vega z najnowszymi sterownikami, może być konkurencją dla GTXa 1080, ale patrząc na cenę, jest trochę bardziej opłacalna...

Zaraz, zaraz. Przecież zwolennicy kart Nvidii szybko zgaszą mój entuzjazm. Karta zmiennie wydajniejsza (w jednych grach lepsza NV, w drugich Radek), ale znacznie bardziej prądożerna i cieplejsza. Tak to wygląda na wielu forach, bo większość użytkowników kart nie ma pojęcia, co jeszcze producent daje nam w pakiecie sterowników. Ale zacznijmy od stereotypów...

Pierwszym i chyba najważniejszym z nich, jest stereotyp, że ilość generowanych FPS’ów, to jest wyznacznik wydajności akceleratów graficznych. Trochę w tym prawdy, ale niestety więcej chwytu marketingowego, napędzanego przez odpowiednie działy sprzedaży firm. Otóż wciąż jeszcze sporo graczy pracuje na monitorach z odświeżaniem obrazu na poziomie 60 Hz. Co to oznacza? Otóż oznacza to tylko tyle, że czy nasza gra osiąga w teście 140 FPS’ów, czy 80 klatek, to gra się w nią równie komfortowo. Tutaj liczy się efekt "placebo", bo olbrzymiej większości graczy wydaje się, że czym więcej, tym lepiej. I to w zasadzie się zgadza, pod warunkiem, że dysponujemy odpowiednim sprzętem.

Firmy produkujące karty graficzne świetnie sobie z tego zdają sprawę, i tylko dla tego stworzyły odpowiednie technologie, które mają popchnąć sprzedaż kart i blisko z nimi spokrewnionych monitorów. Mowa tu o płatnym G-Sync Nvidii i FreeSync AMD (teoretycznie bezpłatnym, choć monitory FS są niemal zawsze ciut droższe od tych bez).

I w tym przypadku ilość klatek ma już znaczenie, bo przeważnie obie technologie wspierają odświeżanie 144 Hz, czyli teoretycznie mamy szansę na wykorzystanie możliwości topowych kart i ustawieniach gry w najwyższych opcjach efektów graficznych. Oczywiście opisuję to w dużym skrócie logicznym, by trafić do statystycznego Kowalskiego, bo w skład wydajności kart graficznych wchodzi znacznie więcej czynników.

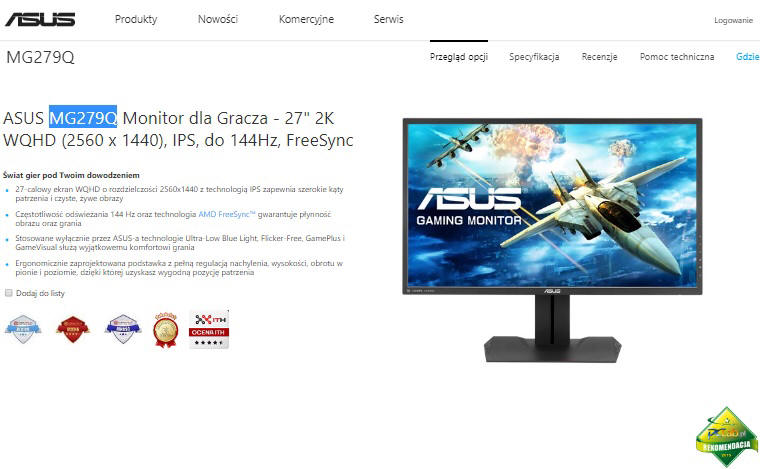

Obietnice producentów, to nie wszystko, bo biorąc pod uwagę na przykład mój monitor ASUS MG279Q, na stronie producenta reklamowany jest, jako wspierający FreeSync 144 Hz... Ale tak naprawdę, sam monitor melduje mi gotowość do współpracy w zakresie 90 Hz. Zwróćcie uwagę, na reklamę i wpis "do 144 Hz. Czyli może być 144 Hz, ale nie musi.

Po prostu Asus uznał, że nie ma sensu w ustawieniu większego odświeżania, bo nic to dla gracza nie daje (opinia zaczerpnięta z zasobów Internetu). Czyli do obsługi takiego monitora wystarczy każda karta, która wygeneruje nam około 100-120 FPS, bo więcej i tak monitor nie jest w stanie wygenerować. Troszkę gorzej jest z FreeSync, jeśli mamy niższą ilość klatek, bo nie zawsze technologia ta przy spadku wydajności w danej scenie gry, może zsynchronizować nam obraz. Wtedy przy mogą się pojawiać lekkie przycięcia np. ziemi, kiedy nasz czołg porusza się do przodu w widoku podglądu zewnętrznego.

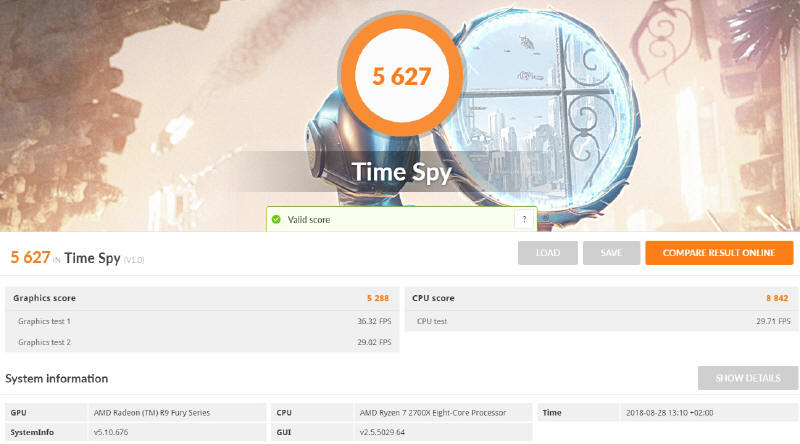

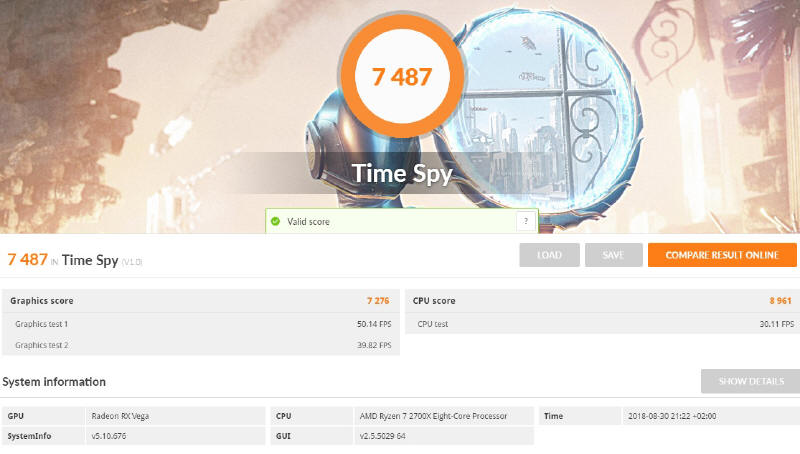

To właśnie (plus dość atrakcyjna cena), przekonało mnie do wymiany FURY X na RX Vegę 64. Ciekawy byłem jednak, jaką wydajność nowy akcelerator graficzny mi doda, bo rozbieżności w testach przeprowadzanych na całym świecie, czasami bywają dość znaczne. Konstrukcyjnie architektura chipu Fury’ego nie odbiega mocno od Vegi (zminiejszono tylko proces technologiczny do 14 nanometrów), więc można by było się spodziewać niedużych różnic z samego podniesienia zegarów pracy GPU. Jednak AMD potrafi poprawiać swoje dzieła, jak choćby kiedyś po dość chłodnym przyjęciu CPU Phenoma wypuścili rewelacyjny układ Phenom II. Podobnie jest z układem Fiji, choć trzeba przyznać, że wzrosty wydajności zostały trochę okupione przez zapotrzebowanie na prąd, ale do tego za chwilę dojdę.

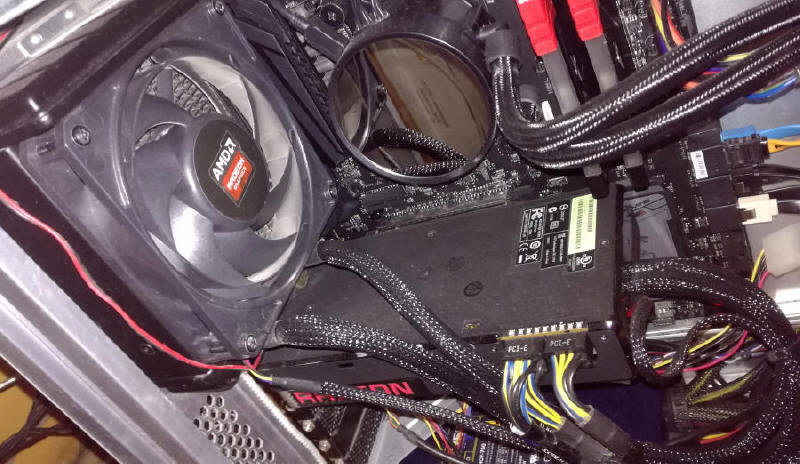

W obu przypadkach musimy podłączyć dwie dodatkowe 8-pinowe wtyczki PCI-e. W swoim komputerze miałem dość mocny pół modularny zasilacz Antec HIGH CURRENT PRO 750W ze "złotym" certyfikatem skuteczności. Posiadał on cztery linie +12V z wydajnością prądową po 40A dla każdej z nich. Dwie stałe wiązki z czterema wtyczkami PCI-e w Fury X wystarczały zupełnie, jednak po podłączeniu Vegi, komputer po włączeniu aplikacji 3D, resetował się. Cóż, 40A to widać za mało. Oczywiście zbawieniem na tą dolegliwość, będzie podłączenie dodatkowego kabla z drugiej linii +12V... Pech tylko chciał, że gdzieś posiałem etui z kablami i przez dwa dni poszukiwań, nie udało mi się ich znaleźć. Pewnie za jakiś czas, gdzieś je wykopię w moim technicznym bałaganie, no ale Antka postanowiłem wystawić na Allegro w stanie, jakim był obecnie, a kupić coś nowego. Wybór padł na w pełni modularny model Corsair HX850, gdzie jest możliwość przełączenia się w tryb jedno lub wieloliniowy. Przy jednej linii mam do dyspozycji natężenie prądu w "rozmiarze" ponad 70A. Tutaj już Vega nie strajkowała i moje czołgi wreszcie ruszyły.

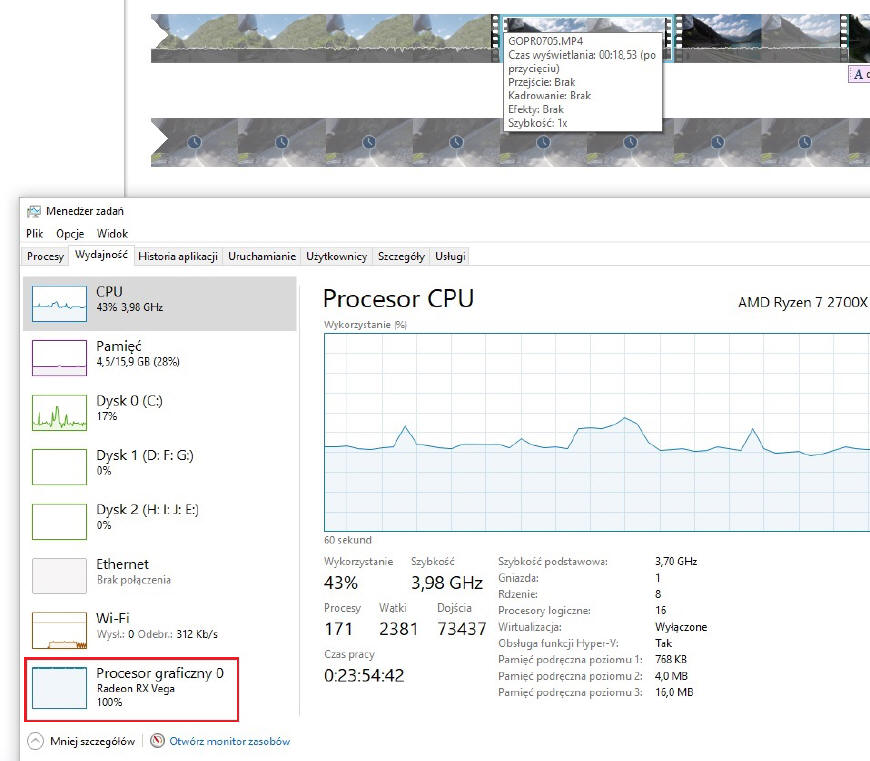

Radeon RX Vega 64 obsługuje funkcje API Vulkan oraz DirectX 12 na poziomie Tier 3, co oznacza wsparcie dla instrukcji Resource Binding, High Performance Async Compute, Conservative Rasterization, Tiled Resources i Shader Intrinsics 6.0+. Brzmi poważnie, prawda? Mnie bardziej interesowało to, że układ Vegi jeszcze szybciej będzie wspomagał CPU przy montowaniu filmów wideo, bo prosty, Windowsowski program Movie Maker, świetnie sobie z tego korzystał w obliczeniach. Poprawa względem "Furego" jest zauważalnie znaczna.

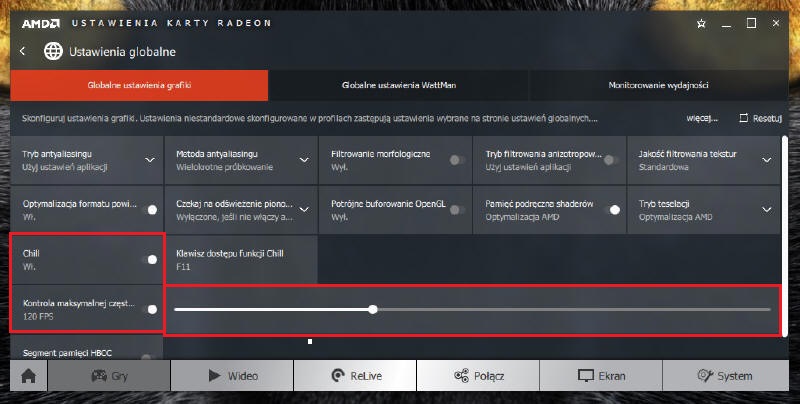

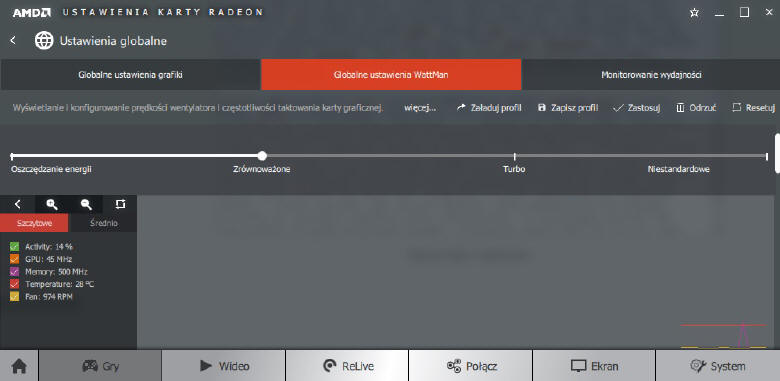

No ale malkontenci powiedzą, co z tego że szybciej, jak za to cieplej i drożej w prądzie. Otóż nie tak do końca. Oczywiście jeśli ktoś ustawi sobie kartę w tryb Turbo, gdzie GPU poddaje się dość mocnemu, fabrycznemu OC, to jego komputer może przekroczyć pobór prądu do ponad 500W. Dlatego AMD w swoich sterownikach dało nam możliwość ustawienia czterech trybów pracy: Power Saver, Balanced, Turbo i ustawień własnych (Global WattMan). Prócz tego dodano narzędzie w postaci technologii Radeon CHILL i kontroli maksymalnej wartości FPS (znajdziecie je w zakładce Ustawienia Globalne).

Radeon CHILL to technologia, która ma na celu obniżenie poboru energii karty, co przekłada się na zmniejszenie temperatur, a w efekcie też hałasu układu chłodzenia. W sporym skrócie myślowym, działa to na zasadzie dynamicznego śledzenia płynności animacji w grach i regulacji zasobów do potrzeb w danej scenie... Przykładowo stoimy sobie "niszczarką" (TD - niszczyciel czołgów) w krzakach, wroga nie widać, na mapie niewiele się dzieje, więc karta sama obniża sobie zasoby potrzebne do zasilania GPU, jednocześnie utrzymując odpowiednią ilość wyświetlanych klatek na sekundę. Kiedy jednak akcja zaczyna się zaostrzać, czołg jest w ruchu, pojawiają się dodatkowe obiekty i efekty wybuchów, GPU zaczyna dobierać sobie dodatkową porcję energii, potrzebną do uzyskania stabilnej pracy akceleratora. Ta technologia potrafi nam zaoszczędzić aż ponad 30 procent energii. Oczywiście zawsze jest coś za coś, więc włączenie tej funkcji może nam nieco obniżyć ilość FPSów. W "czołgach" różnica potrafi sięgnąć nawet 10 klatek, za to cisza wentylatora na chłodnicy, jest nieporównywalna.

A do czego służy ten suwak? Tam "świadomi" użytkownicy "ucinają" sobie zbędne FPSy. Jak już wspominałem, nasz monitor jest w stanie pokazać nam taką ilość klatek, jakie ma maksymalne odświeżanie dla ekranu. Jeśli mamy sprzęt z matrycą zdolną podać 144 Hz, możemy sobie tyle ustawić gdzieś w tych okolicach, jeśli koniecznie tego chcemy. Świadomy użytkownik myśli jednak inaczej. Jeśli do komfortowego grania wystarcza mi na przykład 90 FPS, to tak mogę ustawić, a karta będzie używać tylko część swoich zasobów, co zrobi z niej chłodne i oszczędne urządzenie. W moim monitorze FreeSync osiąga właśnie 90 Hz, więc ustawienie większej ilości, mija się z celem. Karta będzie chodzić w pełnym obciążeniu, a my i tak tego nie zobaczymy.

Oczywiście pomijam tutaj zagadnienie, że monitor 144 Hz może być znacząco lepszy od odpowiedników z niższym odświeżaniem. Takie konstrukcje zdolnym graczom potrafią dać przewagę w grze, dzięki niższej wartości opóźnień sygnału (input lag) i to już zostało udowodnione w testach. Fizyki się jednak nie da oszukać i można tutaj mówić o takich tytułach, jak Counter-Strike: Global Offensive, gdzie najszybsze karty są w stanie wygenerować niemal 300 klatek na sekundę, choć tak naprawdę tego nie zobaczymy. Ta gra potrafi jednak wykorzystać możliwości nowoczesnych monitorów dla graczy i świetnie wpływa na ich sprzedaż, jako reklama na wszelkich imprezach e-sportowych. Oczywiście graczy, którzy w teście na strzelnicy z kropkami są w stanie uzyskać wynik ponad 90 trafień na sto, jest niewielu, ale każdy z młodych, domowych graczy będzie marzył o takim ekranie wierząc, że będzie lepszy od swojego przeciwnika. I to jest własnie dźwignia handlu, wmówić nam, że tego naprawdę potrzebujemy :)

Tutaj ciekawostka, bo Vega 64 w porównaniu z najnowszą obecnie kartą konkurencji GeForce RTX 2080 Ti, w rozdzielczościach FHD i 2K, odstaje na zaledwie o około 20 FPS. To oczywiście świadczy o kresie możliwości CPU, które staje się wąskim gardłem i dopiero włączenie rozdzielczości 4K pokazuje już znaczne różnice. Ale nim monitory 4K na dobre zdominują nasze biurka w domach, minie pewnie jeszcze z dobre trzy, może cztery lata, a to oznaczać będzie zmiany w kolejnych generacjach kart.

Oczywiście nikogo nie chcę przekonywać na siłę do zakupu Radeonów RX Vega 64, ale moim zdaniem warto rozważyć ich zakup, zwłaszcza że można je już nabyć w cenie około 2500 PLN. Z najnowszymi sterownikami są w większości testów wydajniejsze od konkurencyjnego GTX’a 1080, który wciąż jest w sprzedaży (ceny około 2300 PLN). Za wydajniejszą 1080 Ti trzeba już zapłacić ponad 3300 złotych, więc jest się nad czym zastanawiać. Po zmianie z Furego zyskałem w czołgach około 20 FPSów (z maksymalnych 76 do 98 klatek) w trybie oszczędnościowym CHILL, bo po jego wyłączeniu bez trudu dobijam do 110 FPS. Jeszcze lepiej jest w Battlefield 1, gdzie wynik podskoczył z 89 FPS do 123 klatek, a najbardziej widać to w GTA V, w którym wizualna płynność grania wzrosła znacząco (z 55 FPS na 72 FPS - oczywiście we wszystkich grach, mowa o rozdzielczości 2560 x 1440 punktów). Z czegoś różnica w syntetycznym 3DMarku się bierze, więc w jakimś stopniu przełoży się to "w realu", czyli naszych grach.

Co do prądu to fakt, w porównaniu z Fury X bierze trochę więcej. Mój zestaw (cały komputer) z Ryzenem 2700X i sporymi dodatkami na topowej płycie głównej, w spoczynku wahał się na watomierzu od 75 do 80 W, podczas gdy z Vegą już wskazywał od 94 do 108 W. Różnica podczas grania potrafi przekroczyć 100 W, kiedy wyłączymy zarządzanie CHILL (310 W vs 415 W), ale kiedy zdecydujemy się włączyć automatyczną regulację, wynik porównania spada nam nawet o niemal 50 W (310 W vs 369 W). Muszę tutaj też wspomnieć o szybszym wspomaganiu Vegi przy montażu filmów, co przy gigabajtach materiału filmowego zapisanego na kartach pamięci, ma niebagatelne znaczenie.

No to tyle tych wypocin. Może uwagi i wskazówki pomogą komuś przy wyborze i obsłudze kart serii Radeon RX Vega 64, które nie są z pewnością najszybsze, ale dające zupełnie wystarczającą moc dla większości obecnych gier, a dzięki coraz bardziej atrakcyjnym cenom, mogą zachęcić do zmian w Waszej obudowie. To jeszcze parę niusów na stronę i idę grać w czołgi :)